La technologie de conteneurisation est incontournable dans le développement et l’évolutivité des applications modernes. La maîtrise des technologies phares comme Docker et Kubernetes est primordiale à mesure que les entreprises s’appuient de plus en plus sur des workloads conteneurisés.

Docker est une plateforme polyvalente dédiée à la création, à la gestion et à la diffusion de conteneurs sur un hôte unique. Kubernetes est, quant à lui, un instrument d’orchestration s’occupant de la gestion, du déploiement et de la supervision de groupes de conteneurs répartis sur plusieurs nœuds.

Dans cet article, nous nous pencherons sur la manière dont les technologies de conteneurisation, comme Kubernetes et Docker, gèrent les workloads pour des applications évolutives, résilientes et indépendantes des plateformes. Nous discuterons des conteneurs, des runtimes de conteneurs et des moteurs d’orchestration. Nous examinerons ensuite les avantages de l’utilisation conjointe de Kubernetes et de Docker.

Introduction aux conteneurs

La conteneurisation offre aux ingénieurs la possibilité d’associer le code de l’application à ses dépendances spécifiques au sein d’un ensemble allégé appelé « conteneur ». Les conteneurs virtualisent les systèmes d’exploitation et les ressources de la machine, telles que le processeur et la mémoire RAM, en fonction de la consommation prévue. C’est pourquoi bon nombre d’applications distribuées modernes reposent sur des conteneurs. En effet, chaque conteneur dispose de son propre système de fichiers, ce qui permet d’éviter les conflits de dépendance car les ressources ne sont pas mutualisées. Contrairement aux conteneurs, les machines virtuelles sont des copies numériques d’un hôte dont le système d’exploitation et les ressources sont alloués à l’avance.

Pourquoi utiliser un runtime de conteneurs et des moteurs d’orchestration de conteneurs ?

Un runtime de conteneur est un composant logiciel chargé de gérer le cycle de vie d’un conteneur sur un système d’exploitation hôte. Il fonctionne en collaboration avec des moteurs d’orchestration de conteneurs afin de gérer un ensemble distribué de conteneurs de manière simple et efficace. Par exemple, Docker est une technologie de conteneurisation souvent utilisée aux côtés du moteur d’orchestration Kubernetes.

Les moteurs d’orchestration de conteneurs (COE) comme Kubernetes simplifient la gestion des conteneurs et automatisent des tâches complexes. Par exemple :

- Autoscaling des conteneurs

- Configuration des réseaux

- Répartition de la charge

- Réalisation de contrôles d’intégrité

Les COE garantissent l’efficacité des opérations de déploiement des workloads conteneurisés.

Introduction à Docker et Kubernetes

Docker

Le runtime de conteneur est un composant essentiel de Docker. Il fournit l’environnement nécessaire à l’exécution et à la gestion des conteneurs. En tant que technologie dédiée à la conteneurisation, Docker propose une interface facile d’accès sous la forme d’un client Docker, qui traite les workloads sur la machine hôte en communiquant avec le runtime de conteneur appelé Containerd.

Il existe deux types de clients Docker :

- Docker compose : permet de gérer les applications comportant plusieurs conteneurs et de les démarrer ou de les arrêter à l’aide d’une seule commande.

- docker : gère les conteneurs individuellement pour les démarrer, les arrêter ou les supprimer.

Docker prend également en charge d’autres processus de conteneurisation :

- Les images Docker sont créées à l’aide d’un fichier de configuration appelé Dockerfile et sont stockées dans une application sans état (appelée Docker Registry). Les images peuvent être hébergées localement ou dans le cloud (par exemple, via DockerHub).

- Un point de montage est un emplacement du système de fichiers sur lequel un répertoire ou un fichier du système hôte est monté. Lors du démarrage d’un container, Docker crée un point de montage et envoie des alertes au noyau pour allouer le processeur, la mémoire, le disque et les ports hôtes nécessaires.

Malgré ses nombreux atouts, Docker est limité dans les domaines suivants :

- Gestion de plusieurs clusters de conteneurs sur des nœuds distribués en une seule session.

- Opérations en bloc dans un environnement à plusieurs nœuds (comme les conteneurs à autoscaling).

Cependant, Kubernetes permet de surmonter ces limites en gérant les workloads conteneurisés sur un cluster de nœuds.

Kubernetes

Kubernetes est un puissant outil d’orchestration permettant de gérer des conteneurs sur plusieurs hôtes grâce à son interface d’exécution de conteneurs (CRI). La CRI permet à Kubernetes de prendre en charge des plateformes de conteneurisation comme Docker pour créer, supprimer et gérer des conteneurs sur les nœuds de serveur.

Kubernetes simplifie la gestion des clusters en utilisant des objets ressources comme les déploiements, qui considèrent un ensemble de pods d’application (un petit cluster de conteneurs) comme une entité unique. Cette fonctionnalité simplifie le scaling des pods ou la mise à jour des images de conteneurs à l’aide d’une simple commande.

Kubernetes donne aux opérateurs une vue d’ensemble plus étendue du cluster avec une journalisation offrant trois niveaux de détail différents :

- Les logs des conteneurs sont générés en capturant les données stdout et stderr des applications.

- Les logs des nœuds sont agrégés à partir des conteneurs de l’application et conservés conformément à la politique de rotation des logs définie pour chaque configuration de déploiement.

- Les logs des clusters fournissent des informations plus approfondies sur les composants de Kubernetes, comme etcd ou kube-proxy.

En savoir plus

Ce guide met l’accent sur la sécurité de Kubernetes dans le cloud et traite de la surface d’attaque, du cycle de vie de la sécurité et de 12 bonnes pratiques dans ce domaine. À lire : Guide de sécurité Kubernetes

Pourquoi utiliser Kubernetes avec Docker ?

Kubernetes et Docker sont des technologies qui se complètent. Lorsqu’elles sont intégrées, la combinaison des deux technologies peut apporter des avantages significatifs et des capacités accrues.

- Haute disponibilité

- Autoscaling

- Stockage

- Tableaux de bord de surveillance

Haute disponibilité

La limitation de Docker, qui gère les conteneurs uniquement sur un unique nœud hôte sans pouvoir altérer l’état des serveurs, trouve sa solution avec Kubernetes, capable de répartir les conteneurs sur plusieurs nœuds. Kubernetes déploie un nouveau nœud si un nœud existant rencontre une défaillance ou présente des signes de dysfonctionnement. Cette approche garantit une haute disponibilité à tout moment en maintenant une répartition équilibrée du workload.

Autoscaling

Kubernetes offre nativement une fonction d’autoscaling sur les clusters, donnant la possibilité aux utilisateurs d’établir des critères d’ajustement, comme des limites pour diverses métriques (telle que l’utilisation du processeur ou de la mémoire RAM). Lorsque ces seuils sont atteints, comme en cas de trafic intense ou d’une utilisation conséquente du processeur, Kubernetes est en mesure d’ajuster automatiquement les conteneurs. De même, il peut réduire l’échelle des conteneurs lorsque l’utilisation tombe en dessous des seuils fixés. Vous conservez ainsi une faible latence de manière rentable.

Stockage

Pour répondre à la nature souvent éphémère des conteneurs, Docker propose deux modes de stockage persistant : les montages en volume et les montages bind. Cependant, Kubernetes permet de multiples options d’intégration du stockage en abstrayant la couche de stockage des conteneurs. Nous avons ainsi accès aux options suivantes :

- Stockage non persistant

- Stockage persistant (systèmes de fichiers en réseau et Fiber Channel)

- Stockage éphémère (emptyDirs et ConfigMaps)

Tableaux de bord de surveillance

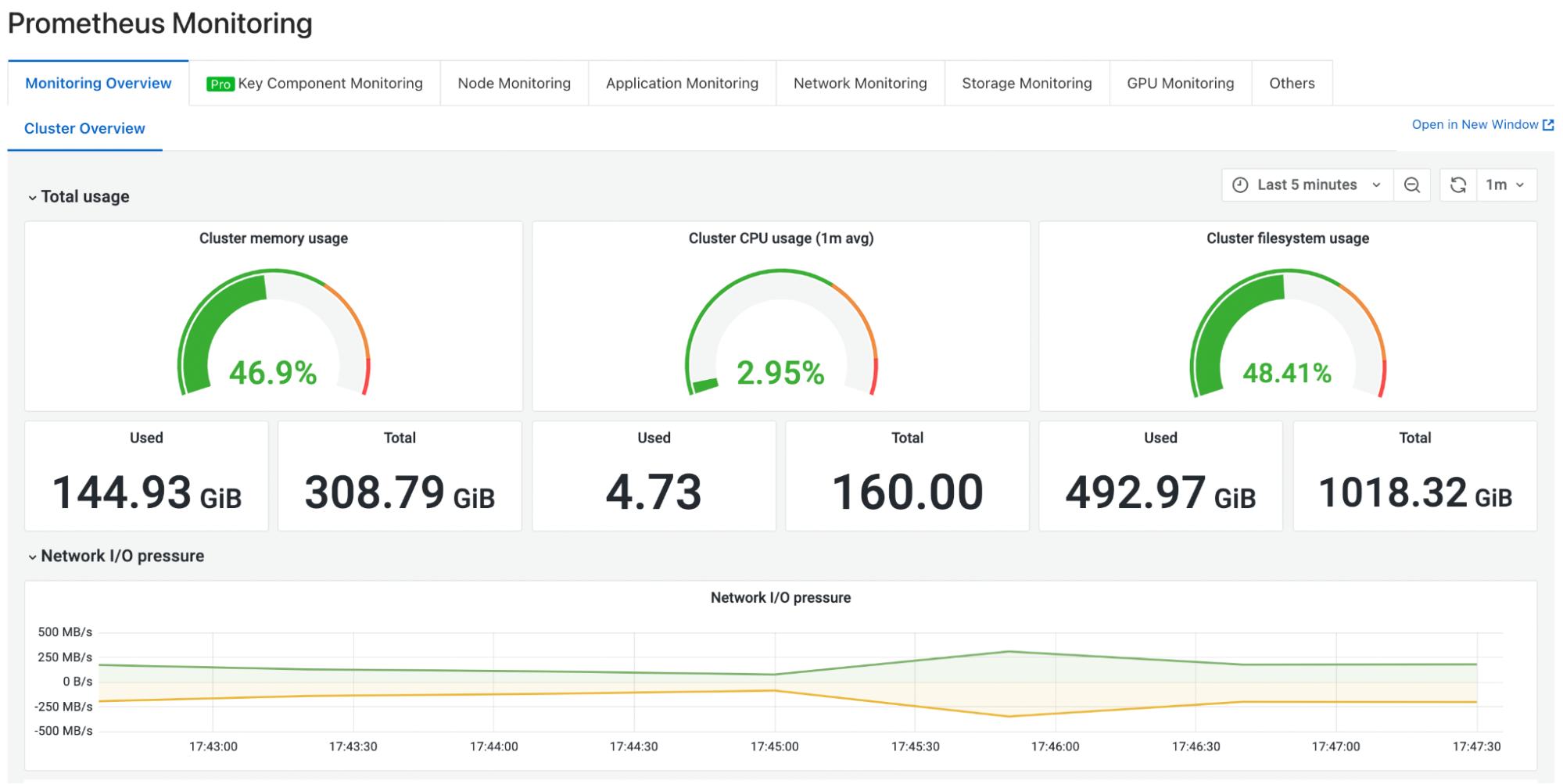

La surveillance est désormais un aspect fondamental de la gestion du cycle de vie des applications. Kubernetes prend en charge l’intégration de divers tableaux de bord afin de fournir une surveillance efficace et des mécanismes d’alerte rapide pour une réponse rapide aux incidents. Les interfaces de Prometheus et Grafana, grâce à leurs tableaux de bord et visualisations, sont réputées pour offrir une expérience utilisateur agréable, intégrant des alertes, une vue d’ensemble et des analyses de diverses métriques au sein d’une infrastructure de microservices.

Tableau de bord Prometheus

Résumé

La technologie de conteneurisation est devenue un aspect essentiel des applications modernes. Les plateformes de conteneurisation comme Docker et les outils d’orchestration tels que Kubernetes se complètent, collaborant pour faciliter la gestion des conteneurs.

Docker est une solution légère qui résout les problèmes de déploiement d’applications dans divers environnements en regroupant une application avec ses dépendances. Kubernetes s’appuie sur la conteneurisation avec ses fonctionnalités avancées, permettant une visibilité et un contrôle plus larges sur les clusters exécutant des workloads complexes.

Lorsqu’ils sont combinés, Docker et Kubernetes facilitent le déploiement, la gestion et la scalabilité d’écosystèmes distribués et complexes.